多显卡训练的基本原理

在多张显卡训练时,深度学习模型的训练过程被拆分成多个子任务,分配到不同的显卡上。通常有以下几种主要的并行方式:

数据并行:将训练数据划分为几个批次,各个显卡独立处理一部分数据。每张显卡计算得到的梯度会在反向传播阶段进行汇总。

模型并行:将模型的不同部分分配到不同的显卡上,适用于大型模型,但管理起来较为复杂。

常用深度学习框架支持多显卡的方式

在许多深度学习框架中,如 TensorFlow 和 PyTorch,均提供了多显卡训练的支持。以下展示的是如何在 PyTorch 中实现数据并行训练的基本示例。

PyTorch 多显卡训练示例

1. 环境准备

首先,确保安装了 PyTorch 和 torchvision 库。可以使用 pip 命令进行安装:

pip install torch torchvision

2. 代码示例

以下代码示例展示了如何使用 PyTorch 在多张显卡上进行训练:

import torchimport torch.nn as nnimport torch.optim as optimfrom torchvision import datasets, transformsfrom torch.utils.data import DataLoader# 定义简单卷积神经网络class SimpleCNN(nn.Module): def __init__(self): super(SimpleCNN, self).__init__() self.conv1 = nn.Conv2d(1, 32, kernel_size=3, stride=1, padding=1) self.fc1 = nn.Linear(32 * 14 * 14, 10) # 假设输入图像为 28x28 def forward(self, x): x = self.conv1(x) x = nn.ReLU()(x) x = nn.MaxPool2d(kernel_size=2, stride=2)(x) # 下采样 x = x.view(-1, 32 * 14 * 14) x = self.fc1(x) return x# 数据加载transform = transforms.Compose([ transforms.ToTensor(),])train_dataset = datasets.MNIST(root='./data', train=True, transform=transform, download=True)train_loader = DataLoader(train_dataset, batch_size=64, shuffle=True)# 检查可用的显卡device = torch.device("cuda" if torch.cuda.is_available() else "cpu")model = SimpleCNN().to(device)# 使用数据并行if torch.cuda.device_count() > 1: model = nn.DataParallel(model)# 损失函数和优化器criterion = nn.CrossEntropyLoss()optimizer = optim.Adam(model.parameters(), lr=0.001)# 训练模型num_epochs = 5for epoch in range(num_epochs): for images, labels in train_loader: images, labels = images.to(device), labels.to(device) # 梯度清零 optimizer.zero_grad() # 向前传播 outputs = model(images) # 计算损失 loss = criterion(outputs, labels) # 向后传播 loss.backward() # 更新参数 optimizer.step() print(f"Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item():.4f}")

运行解释

在上述示例中,首先定义了一个简单的卷积神经网络,并创建了一个数据加载器。我们使用 torch.device 来检查是否有可用的 GPU,并将模型放到GPU上。通过使用 nn.DataParallel,我们可以使模型在多张显卡上运行。然后,在训练循环中,将数据和标签移动到 GPU,并进行前向传播、反向传播和参数更新。

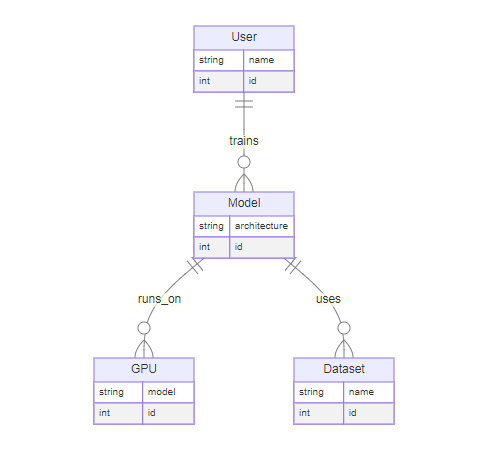

关系图

为了更好地理解多显卡训练中的各个组件及其相互关系,以下是一个关系图示意:

联系我们

福建星海湾网络科技有限公司

服务项目

开启智能制造 从我们开始